Los 10 momentos más importantes en IA (hasta ahora)

La inteligencia artificial todavía está en su juventud. Pero algunas cosas muy grandes ya han sucedido. Algunos de ellos captaron la atención de la cultura, mientras que otros produjeron ondas de choque que se sintieron principalmente dentro de los confinados confines de la academia. Estos son algunos de los momentos clave que impulsaron a la IA hacia adelante de la manera más profunda.

1. ISAAC ASIMOV ESCRIBE LAS TRES LEYES DE LA ROBÓTICA (1942)

La historia de Asimov "Runaround" marca la primera vez que el famoso autor de ciencia ficción enumera sus " Tres leyes de la robótica " en su totalidad:

Primera ley: un robot no puede dañar a un ser humano o, por inacción, permitir que un ser humano sufra daños.

Segunda Ley: Un robot debe obedecer las órdenes que le dan los seres humanos, excepto cuando tales órdenes entren en conflicto con la Primera Ley.

Tercera Ley: Un robot debe proteger su propia existencia siempre que dicha protección no entre en conflicto con la Primera o Segunda Ley.

"Runaround" cuenta la historia de Speedy, un robot en una situación en la que parece imposible equilibrar la tercera ley con las dos primeras. Las historias de Asimov en la serie Robot hicieron que los fanáticos de la ciencia ficción, algunos de ellos científicos, pensaran en la posibilidad de pensar en máquinas. Incluso hoy, muchas personas pasan por el ejercicio intelectual de aplicar las leyes de Asimov a la inteligencia artificial moderna .

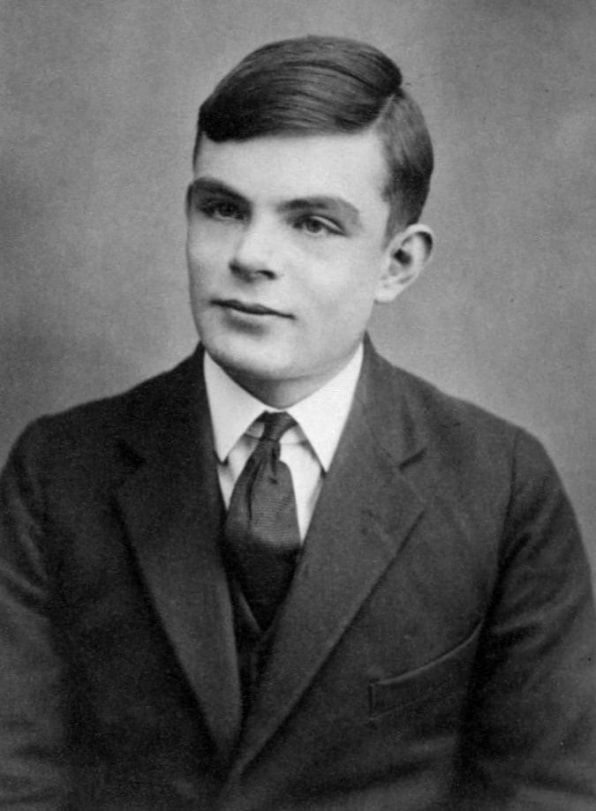

2. ALAN TURING PROPONE EL JUEGO DE IMITACIÓN (1950)

Esa pregunta teórica dio origen al famoso "Juego de imitación" de Turing, un ejercicio en el que se desafía a un "interrogador" humano a diferenciar entre las respuestas de texto de una máquina y un ser humano. Ninguna máquina capaz de pasar una prueba como esa existió en la era de Turing, o lo hace hoy. Pero su prueba proporcionó un punto de referencia simple para identificar la inteligencia en una máquina. Ayudó a dar forma a una filosofía de inteligencia artificial.

3. DARTMOUTH CELEBRA UNA CONFERENCIA DE IA (1956)

Para 1955, los científicos de todo el mundo habían comenzado a pensar conceptualmente sobre cosas como las redes neuronales y el lenguaje natural, pero no había un concepto unificador que envolviera varios tipos de inteligencia artificial. Un profesor de matemáticas del Dartmouth College llamado John McCarthy acuñó el término "inteligencia artificial" para encapsularlo todo.

McCarthy dirigió un grupo que solicitó una subvención para celebrar una conferencia de IA al año siguiente. Invitaron a muchos de los principales investigadores avanzados de ciencias del día a Dartmouth Hall para el evento en el verano de 1956. Los científicos discutieron numerosas áreas potenciales de estudio de IA, incluyendo aprendizaje y búsqueda, visión, razonamiento, lenguaje y cognición, juegos (particularmente ajedrez) e interacciones humanas con máquinas inteligentes, como robots personales.

El consenso general de las discusiones fue que la IA tenía un gran potencial para beneficiar a los seres humanos. Produjeron un marco general de áreas de investigación donde la inteligencia artificial podría tener un impacto. La conferencia organizó y activó la IA como disciplina de investigación en los años venideros.

Relacionado: Para comprender la inteligencia artificial en 2019, vea este programa de televisión de 1960

4. FRANK ROSENBLATT CONSTRUYE EL PERCEPTRON (1957)

Pero los perceptrones existían mucho antes que las computadoras poderosas. A fines de la década de 1950, un joven psicólogo investigador llamado Frank Rosenblatt construyó un modelo electromecánico de un perceptrón llamado Mark I Perceptron , que hoy se encuentra en el Smithsonian. Era una red neuronal analógica que consistía en una red de células fotoeléctricas sensibles a la luz conectadas por cables a bancos de nodos que contenían motores eléctricos con resistencias rotativas. Rosenblatt desarrolló un "Algoritmo de Perceptrón" que dirigía a la red a ajustar gradualmente sus puntos fuertes de entrada hasta que identificaran correctamente los objetos, permitiéndole aprender de manera efectiva.

Los científicos debatieron la relevancia del Perceptrón hasta bien entrada la década de 1980. Era importante para crear una encarnación física de la red neuronal, que hasta entonces había sido principalmente un concepto académico.

5. LA IA EXPERIMENTA SU PRIMER INVIERNO (AÑOS 70)

La inteligencia artificial ha pasado la mayor parte de su historia en el ámbito de la investigación. Durante gran parte de la década de 1960, agencias gubernamentales como la Agencia de Proyectos de Investigación Avanzada de Defensa de los Estados Unidos (DARPA) invirtieron dinero en investigación y preguntaron poco sobre el posible retorno de su inversión. Y los investigadores de IA a menudo exageran el potencial de su trabajo para poder mantener su financiación. Todo esto cambió a fines de la década de 1960 y principios de los 70. Dos informes, el Comité Asesor automática Procesamiento del Lenguaje (ALPAC) informe al Gobierno de Estados Unidos en 1966, y el informe LighthillPara el gobierno británico en 1973, analizó la investigación de IA de manera pragmática y devolvió análisis muy pesimistas sobre el potencial de la tecnología. Ambos informes cuestionaron el progreso tangible de varias áreas de investigación de IA. El Informe Lighthill argumentó que la IA para tareas como el reconocimiento de voz sería muy difícil de escalar a un tamaño útil para el gobierno o el ejército.

Como resultado, tanto el gobierno de los EE. UU. Como el gobierno británico comenzaron a cortar los fondos para la investigación universitaria de IA. DARPA, a través del cual la financiación de la investigación de IA fluyó libremente durante la mayoría de los años 60, ahora exigía que las propuestas de investigación vengan con plazos claros y descripciones detalladas de los resultados. Eso dejó a AI como una decepción que nunca podría alcanzar capacidades de nivel humano. El primer "invierno" de AI duró a lo largo de los años 70 y hasta los 80.

6. LLEGA EL SEGUNDO INVIERNO DE IA (1987)

La década de 1980 comenzó con el desarrollo y el éxito de los " sistemas expertos " , que almacenaban grandes cantidades de conocimiento de dominio y emulaban la toma de decisiones de expertos humanos. La tecnología fue desarrollada originalmente por Carnegie Mellon para Digital Equipment Corporation, y las corporaciones implementaron la tecnología rápidamente. Pero los sistemas expertos requerían hardware costoso y especializado, que se convirtió en un problema cuando las estaciones de trabajo de Sun Microsystems y las computadoras personales de Apple e IBM estuvieron disponibles con potencia comparable y precios más bajos. El mercado de las computadoras de sistemas expertos se derrumbó en 1987, y los principales proveedores de las máquinas dejaron el mercado.

El éxito de los sistemas expertos a principios de los años 80 había alentado a DARPA a aumentar los fondos para la investigación de inteligencia artificial, pero eso cambió nuevamente ya que la agencia volvió a cortar gran parte de la financiación a la inteligencia artificial para todos los programas, excepto algunos. Una vez más, el término "inteligencia artificial" se volvió casi tabú en la comunidad de investigación. Para evitar ser vistos como soñadores poco prácticos que piden financiación, los investigadores comenzaron a usar diferentes nombres para el trabajo relacionado con la IA, como "informática", "aprendizaje automático" y "análisis". Este segundo "invierno de IA" duró hasta la década de 2000.

7. DEEP BLUE DE IBM VENCE A KASPAROV (1997)

Deep Blue tenía mucha potencia informática, y utilizó un enfoque de "fuerza bruta", evaluando 200 millones de movimientos posibles por segundo para encontrar el mejor posible. Los humanos tienen la capacidad de examinar solo unos 50 movimientos por turno. El efecto de Deep Blue fue similar a la IA, pero la computadora en realidad no estaba pensando en la estrategia y el aprendizaje como jugó, como lo harían los sistemas posteriores.

Aún así, la victoria de Deep Blue sobre Kasparov devolvió la inteligencia artificial a la mente pública de una manera impresionante. Algunas personas estaban fascinadas. Otros se sentían incómodos con una máquina que golpeaba a un jugador de ajedrez humano de nivel experto. Los inversores quedaron impresionados: la victoria de Deep Blue hizo que las acciones de IBM subieran $ 10 a su máximo histórico.

8. UNA RED NEURONAL VE GATOS (2011)

Para 2011, los científicos de universidades de todo el mundo estaban hablando y creando redes neuronales. Ese año, el ingeniero de Google Jeff Dean conoció a un profesor de informática de Stanford llamado Andrew Ng. Los dos nacieron la idea de construir una gran red neuronal, dándole poder informático masivo utilizando los recursos del servidor de Google, y alimentando un conjunto masivo de datos de imágenes.

La red neuronal que construyeron funcionaba con 16,000 procesadores de servidor. Le dieron 10 millones de capturas de pantalla aleatorias y sin etiqueta de YouTube. Dean y Ng no le pidieron a la red neuronal que presentara ninguna información específica o que etiquetara las imágenes. Cuando las redes neuronales se ejecutan de esta manera sin supervisión, naturalmente intentarán encontrar patrones en los datos y formarán clasificaciones.

La red neuronal procesó los datos de la imagen durante tres días. Luego devolvió una salida que contenía tres imágenes borrosas que representaban patrones visuales que había visto una y otra vez en las imágenes de prueba: un rostro humano, un cuerpo humano y un gato. Esa investigación fue un gran avance en el uso de redes neuronales y el aprendizaje no supervisado en tareas de visión por computadora. El evento también marcó el inicio del proyecto Google Brain.

9. GEOFFREY HINTON DESATA REDES NEURONALES PROFUNDAS (2012)

La victoria fue un fuerte argumento de que las redes neuronales profundas que se ejecutan en procesadores gráficos eran mucho mejores que otros sistemas para identificar y clasificar con precisión las imágenes. Esto, tal vez más que cualquier otro evento, inició el renacimiento actual en redes neuronales profundas, lo que le valió a Hinton el apodo de "padrino del aprendizaje profundo". Junto con sus compañeros gurús de la IA, Yoshua Bengio y Yann LeCun , Hinton ganó el codiciado Premio Turing por 2018.

10. ALPHAGO DERROTA AL CAMPEÓN DE HUMAN GO (2016)

En 2013, investigadores de una startup británica llamada DeepMind publicaron un artículo que mostraba cómo podían usar una red neuronal para jugar y vencer a 50 viejos juegos de Atari. Impresionado, Google arrebató la compañía por unos $ 400 millones. Pero los días de gloria de DeepMind estaban por delante.

Varios años después, los científicos de DeepMind, ahora dentro de Google, pasaron de los juegos de Atari a uno de los desafíos más antiguos de la IA, el juego de mesa japonés Go. Desarrollaron un modelo de red neuronal llamado AlphaGo que fue diseñado para jugar Go y aprender jugando. El software jugó miles de juegos contra otras versiones de AlphaGo, aprendiendo de sus estrategias ganadoras y perdedoras.

Funcionó. AlphaGo derrotó al mejor jugador de Go del mundo, Lee Sedol, cuatro juegos contra uno en una serie de juegos en marzo de 2016. Todo el asunto fue capturado en un documental . Mirándolo, es difícil pasar por alto la sensación de tristeza cuando Sedol es derrotado. Parecía que los humanos, no solo un humano, habían sido derrotados.

Los avances recientes en las redes neuronales profundas han tenido un impacto tan amplio que la verdadera historia de la inteligencia artificial puede estar apenas comenzando. Todavía habrá mucha esperanza, exageración e impaciencia, pero ahora parece claro que la IA tendrá un impacto en todos los aspectos de la vida del siglo XXI, posiblemente en formas aún más profundas que Internet.